#音楽

歴代で好きだったところだとピノキオピーとかぬゆりさんとか、いいんだけど、控えめなんだよな。実際。品を保っているというか。前者は皮肉で、後者は冷笑で

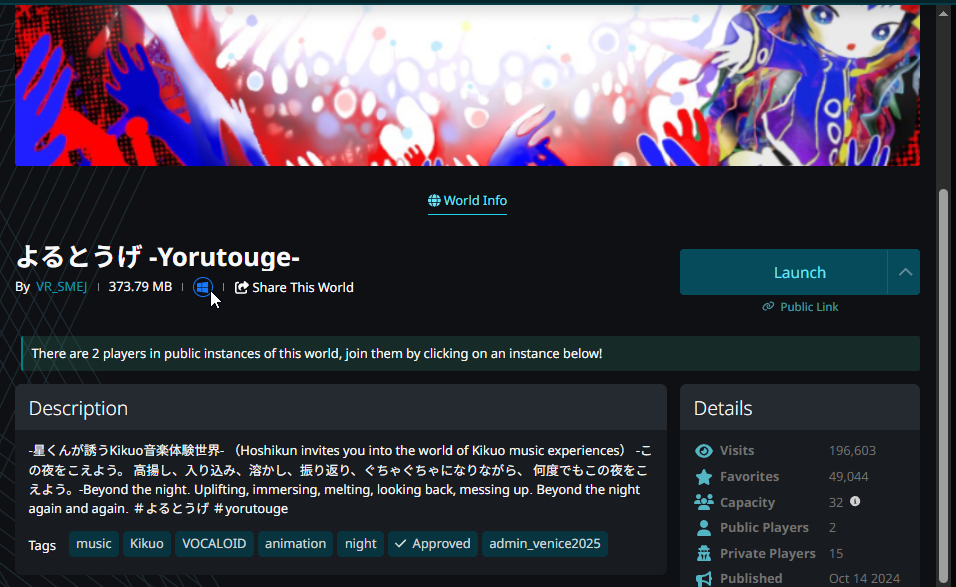

雨乃こそあどさんはもうちょい強いかもしれない。きくおさんはちょっとズレる(シニカルさとかではない)けどあんま抑えてない、感じはある。(最近の作品は丸くなった、落ち着いた、とも言える気がしないでもないが、変化は必ずしも悪ということでもないだろう)

その点でA4。さんはまだ丸くない感じ

#開発

tampermonkeyスクリプトをtypescriptで書けるようにした。(webpack→tamperdav)

コードの更新で、コンパイル→同期まで行われる

実行中のタブ/URL上で更新につき更新が適用されるようにするのはまだだが、適当に1dごととかでreloadするか、適時にしたいならwebsocketなりでシグナル送るなりやりようはいくらでもある

ユーザスクリプトがvscode+typescript+copilot+webpack環境で書けるのは助かるわ。保守も楽になりそうだし、金取るにしてもwebpackで難読化/電子透かし/コメント処理とかも楽になる。

2,3年前くらいから構想してたシステムだったが着手すればすぐだった

フルスタックエンジニア/full-stack developerって言葉、みんな使うよね。

だから僕はもう使わない。ダサいし。

なんかそういうとこで勝負するの疲れるなって。そうも思う

まあ僕の場合は全く実力が伴ってるから勝負も何もないんだけど

実力があるなら誰にも雇われる必要がないはずであると思う。だってフルスタックなんだろ?

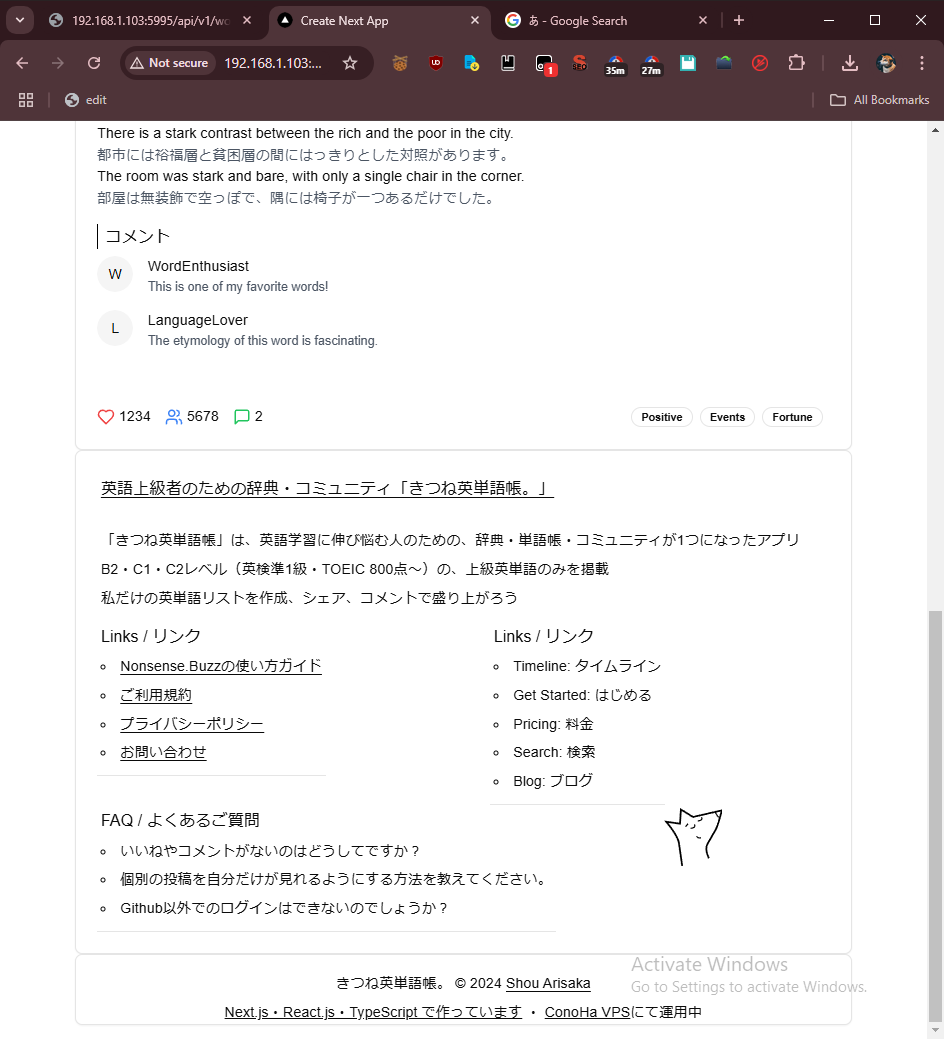

アイデア出てから3時間で作れました

まだ準備中故、googleに見つからないように一時ディレクトリに入れてある。ただ簡易なアプリだし、もう試せるから

URL貼ると見つけられるので貼れないけど、画像に出てるURLでアクセスできます一応

明日くらいに整備して公開すると思う

このアプリのデザインいいよな。ミニマル・綺麗めで万人受けする感じ

真似させてもらおうかな

白基調のミニマルがUIトレンドなんだよな…人を選ばないのもあるけど、デザインに(認知)コスト掛からないってのと重くならない(SEOジレンマに陥らない)

nonbuz作りながらずっとこういう凝り方はやっぱり要らんかったよなあ…って思ってた。崩さないけどね。これからスクラッチで作ってくサービスに効かせていく。

react-jsonschema-form。ネストするjson/jsオブジェクトのユーザインプットに最適。

1,2年とか前からスターはしてたけどちゃんと使ったことはなかった。

配列の追加、移動、そういうのもユーザフレンドリーに実装できる。

これはなかなかコード量が削減できそう…。

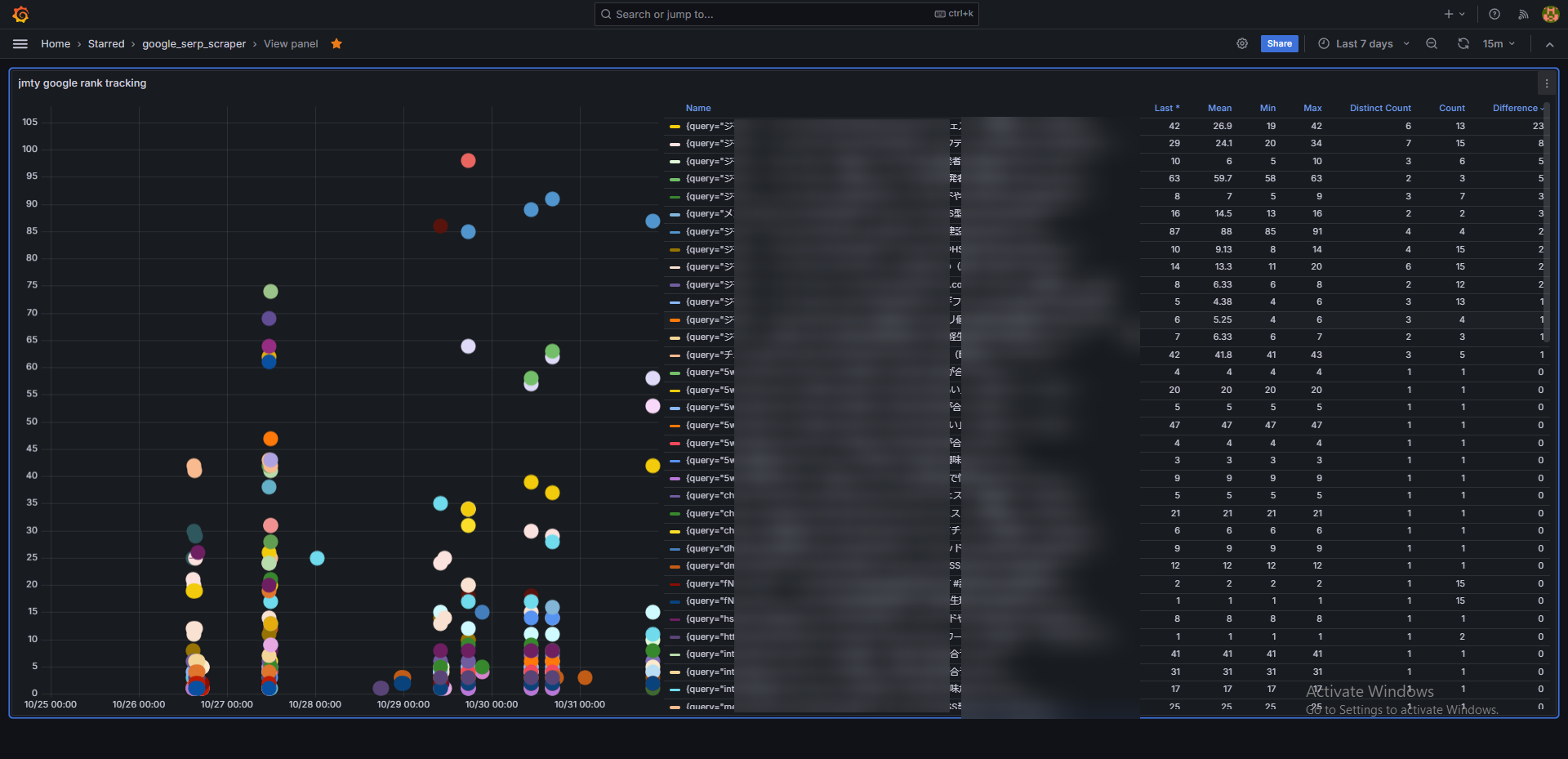

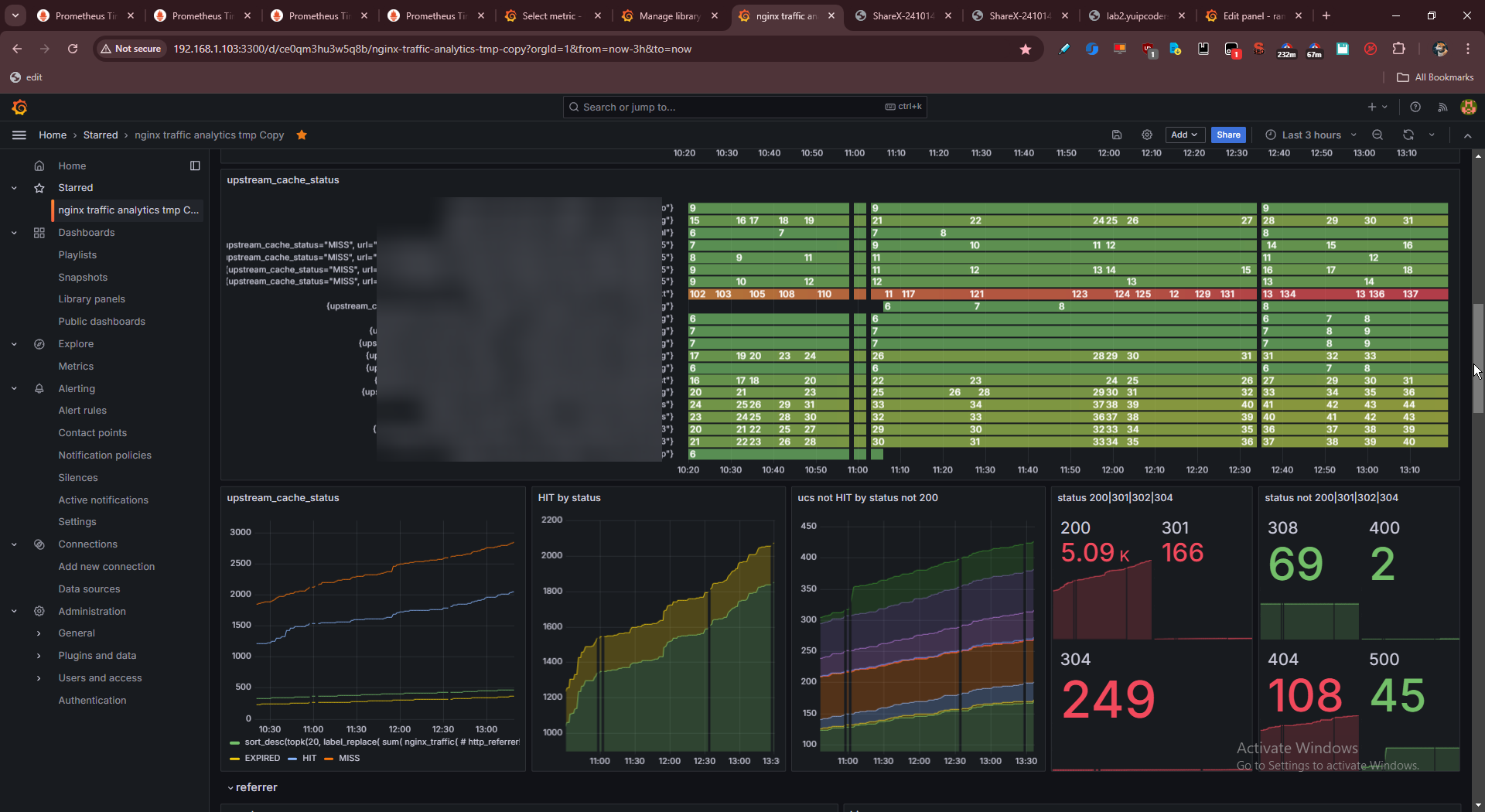

Google検索結果順位のgrafana/prometheusトラッキング分析ツール。ちなみに。

検索からこの投稿見つけて欲しい人いれば作り方(使い方・ダッシュボード・コード)なら売れます。データは売れない。

javascriptだけでかなり長い期間書いてたからなあ…

もっというとbash(linux)をかなり書いている。もう全然書かない…。

書いてる言語で並べるとjs > bash > python > php > java > ruby/rails/jinja/liquid > typescript > sql/sparql/plpgsql > rust > c++, c#, r, powershell, vb/vba, dart etc... ってところかな。

思いついた感じだから漏れ言語ありそうだけど

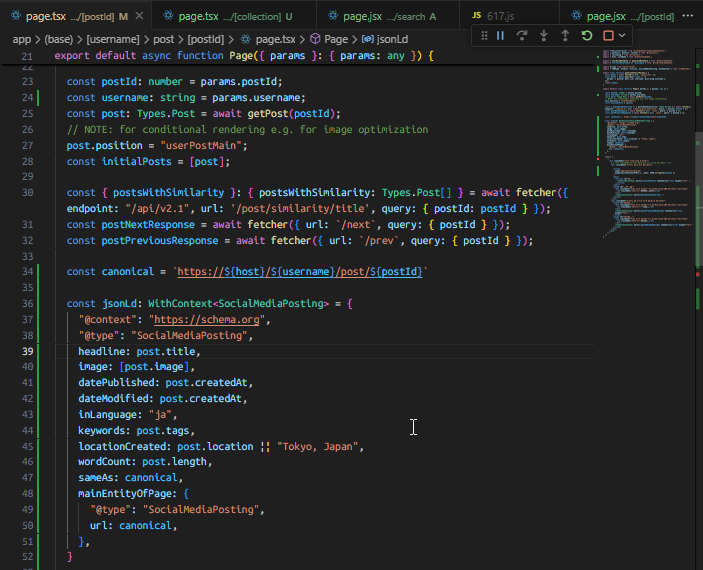

schema-dts使いながらschema(json-ld, structured data)を整えてる。typescriptはやっぱ、面倒だけど使いやすい。型ってのは大事だよなあ。型の概念は日常生活でも使えると思う。たぶん

#技術

tmuxで間に合ってはいるんだけど、windows/powershellでのマルチプレクサの選択肢として。windows terminalもconemu/GuiMacroも限界が来てて。adminコマンド系は下手にwsl(v1)で解決しようとするとブルースクリーンなるし。

Luaはたまにnginxで触ってたけど、良い言語だと思う。シンプリスト哲学で敷居が低いのがいい。プログラマブルコンフィグって概念が素敵。

vlcの拡張プラグインもLuaだけど、デバッグがログオンリーでとても開発はできない。やっぱ型駆動に慣れてるとなあ…

書くには書けるけど、開発ベストプラクティスは模索中。

hey(web3分散型オープンソースSNS)少し前に立てようとしたけどエラーで無理だったんだよな

やってみたい…

ただ13000コミットって、wordpress化してるな…。コード改造したいからミニマルシンプルなプロジェクトの方がいいんだけど…。

相変わらずgrafanaばかり触っている。学習曲線がな

まだnginxログ表示の最適解を模索している。

overrideっていうのが便利というか深い。昨日くらい触り始めたけど

これ↑は上(0以上)と下で違うデータを表示させている例。上には合計、下には細かいブレイクダウンを表示させている。(データ値に*-1をするとチャートをひっくり返せるけどデータ値も変わるので避けたい。transform -> negative yならデータ値そのままでupside downできる)

overrideは色々使えると思う。まあ、データごとにデータの表示方法を変えれる。線を直線かダッシュか色とかで分けるとか。設定自体は手動だから面倒だけど(json弄るってのもできるだろうけど。api的なのがあるかもしれない)

あとmax値が1以下の値についてチャートを表示させないとか。全部表示させると見にくくも重くもなるから

逆にでかすぎる値、例えば>=500とかでフィルタとかもできる。欲を言えればこの500とかの部分も計算で充てさせてほしいところだけど(全体の97thパーセンタイルの値で、とか)

right y axis、つまり2つ目のプロット表示もできるっぽいけど、よく掴めていない。一方を線形、一方をlogとかにすると右側軸に出るけど、それ以外の方法が分からない。

まあ、grafanaはreactベースなので弄ろうと思えば改造できるはずだし。適当に触っていく

rel=terms-of-serviceなんてあるのか……html全然分からん。

言うて僕の知識浅いなあ…rel=tagとかも知らなかったし

追記。じゃあプライバシーポリシーもあるんじゃね?と思ったらrel=privacy-policyもあった…。

なんかもう、これがガイドブックじゃん。

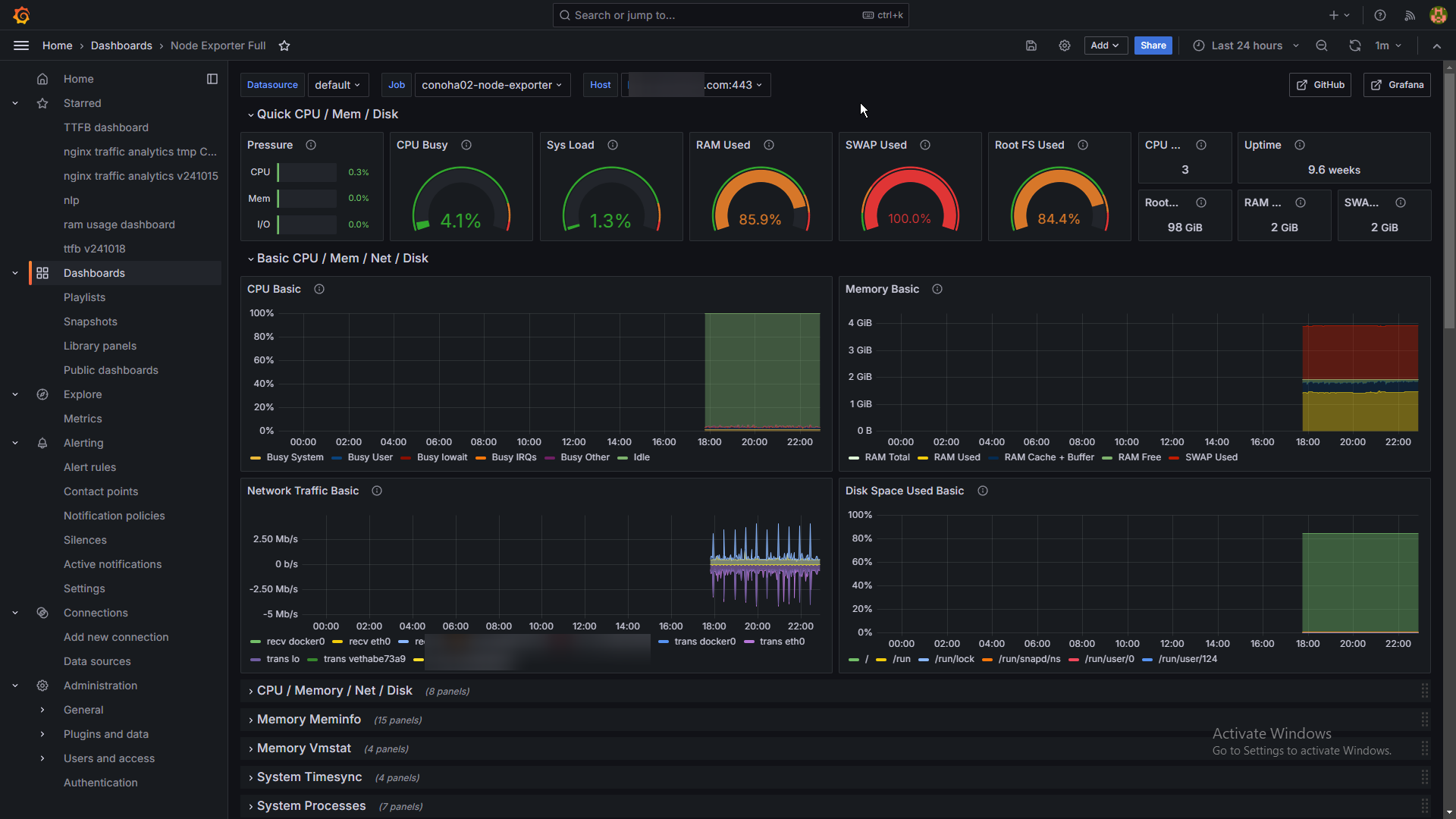

grafana。prometheus/node_exporterとNode Exporter Fullダッシュボードを組み合わせ。

windowsでもlinuxでも作れます。

これが本来のgrafanaの使い方だよな…オブザーバビリティ。僕みたいなNLPとかnginxのアクセス分析とか使い方はちょっとアウェイ。

データ量がすごい。重そう……ここまでリッチだとnetdataとどう違うんだってなってしまうな。シンプルさはもはやない…

僕より技術力あるなって人そうそう見えないんだけど(弱い人が多すぎる?)、

nginxのパフォーマンスチューニングでこれ見てるけど

2割くらいしか理解できない…

SYNsとか出だしたところからついていけない。

まあこれについては知らないだけでググればいいんだろうけど

ぱっと過去ログちら見したけど、知識量がえぐい

知識量っていうかレベル高いことやってる。前提知識がないとできない事々

まあ、僕の上の人間だ(少なくとも技術の側面において)ってのが明確に分かる。

インフラ・ネットワークetcが主軸な人っぽいけど、ちゃんとプログラムも書いてるしrpcとか僕わからんし…。当たり前のようにgrafana/prometheusも経験されてる。

こういう人を見つけると少し嬉しい。(qiitaとかのレベルが低いのかな…)

これは作為的だよな、見たところ。

だから、想像するに、なんでか分からないけど、

ネット回線がとても早い環境の人がいる。また、ネット回線が少し弱い他の人がいる。後者の彼がアクセスした時には300msくらいで準備が整い、でもexample .com側であと200ms(なぜか?)待たされる処理をしてから、合計500msで受け取る。前者の彼の場合は60msで本来受け取れるけど、440msくらい待機時間が"足されて"、500msくらいで受け取る。

みたいな、よく分からない仕様になっているみたいだ。

さすがインターネットの影の支配者なだけはあるな。知らんけど

grafanaにてttfb(ping・rtt)の分析。昨日くらいにセットアップして走らせていた。

面白い図。安定?してくれているっぽいのはいい。

example .comだけ異色。僕のサイト群、サーバーだけでなくipifyとか他のも含めているから、でもipifyとは連動している。

example .comだけ…超安定してるっぽい。これは何なんだろうな

しかしgrafanaは面白い。

使えるようになるまでの学習曲線がっていうか敷居めっちゃ高いけど(grafanaがっていうよりデータの用意、整形、サーバ設定、何よりprometheusとpromqlを含めた諸々が)

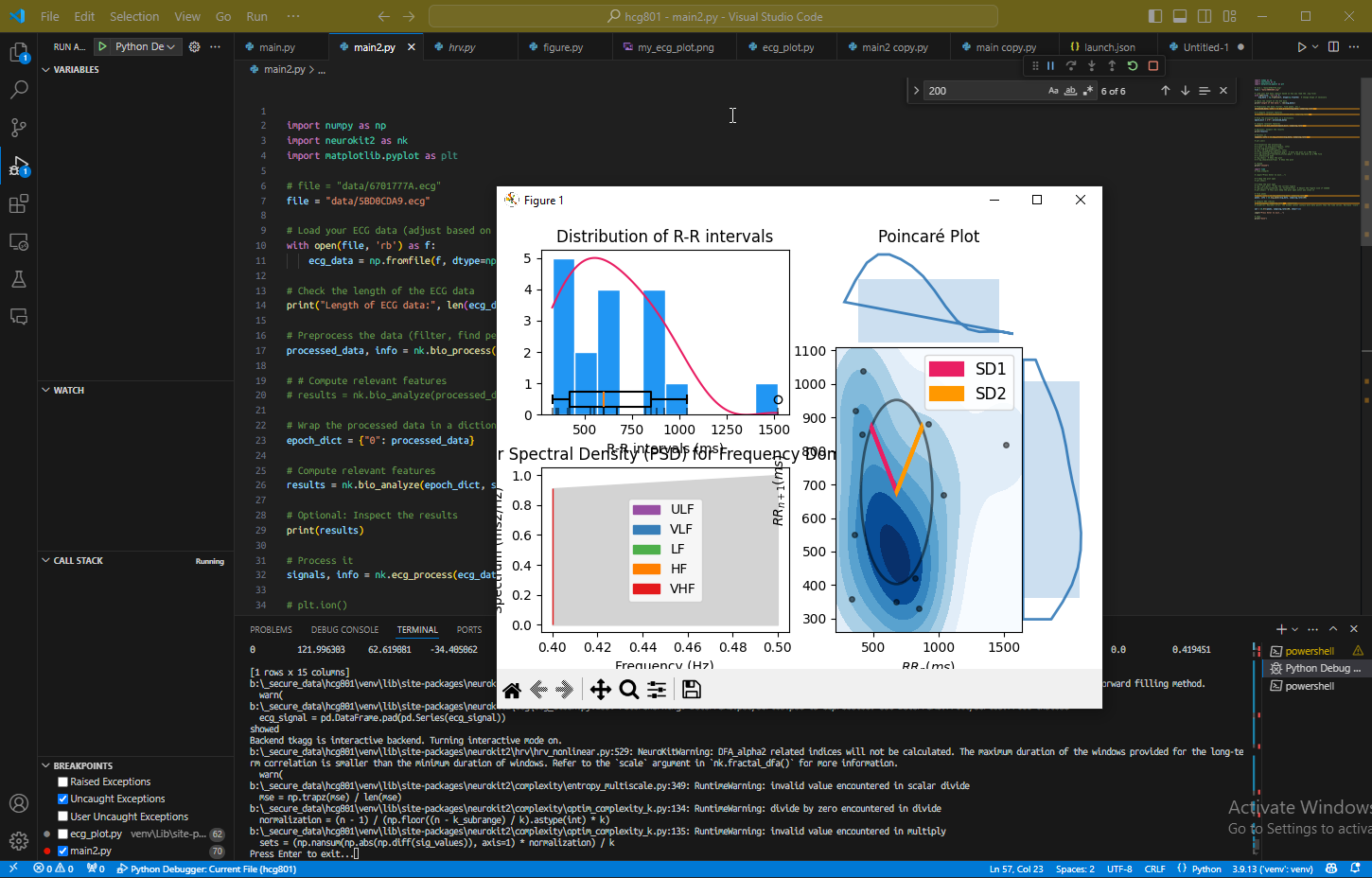

NeuroKitでECGの生体信号処理とHRVの分析してみた。

神経生理学系NeuroKitでECG(心電図記録)の生体信号処理および心拍変動(HRV)の分析してみた。

テストのつもりだったので2018年に僕の心電計で取ったデータでプロット。

pythonライブラリ↓

ちゃんとデータ見てないし見方これから学ぶけど

動かすのに2時間くらい要したな…。

下調べで2時間弱くらい

知見がないのでこんな感じのバイオメトリクス晒すのがやばいのかやばくないのかは分からないけど

随分前に取ってあったデータだから取り方とか下手だったかも分からないけど

このNeuroKitは他にも皮膚電位、脈波、筋電図記録、眼球図記録 etc色々使えるっぽい

計量生物学領域前から参入したかったから助かる。

これは新しいおもちゃになりそう。

grafana。まあまあそれっぽいダッシュボードになってきた

正直gaはgaで見やすいんだよな…

でもgaは入れたくないし入れるつもりない。

でもgoogleアナリティクスでhttpステータスは…見れるな、でも算出方式が不明だし実際値と違うじゃんってこともよく起こる。中がブラックボックス。

でもgaはgaで使いやすいとこもある。でも追加の設定とかもトラッキング複雑にするなら必要になるし

nginxログ駆動の分析は何にでもグローバルに使えるのがいい。全部urlベースド。

まあ例えばurlごとのリファラーとかはgaの領域外。

robots/sitemap/feedとか特定ルートでuseragent取る、みたいなアグリゲーションはできない…はず。

もちろんnginx特有というかカスタムヘッダ(X-ヘッダ)、upstream_cache_statusとかもそうだけどそういうののモニタリングはできない…はず。

そんなことはgaにはできないはず。すごい弄くればできるのかもしれないけど

でもそもそもnginx側でリクエストレスポンス止まったり削られたりする場合はクライアントjsまで届かないわけだから、リバースプロキシっていう低レイヤー層で抜くのは理にかなってると思っている。

だから現に僕がこれまで運用してたjsによるテレメトリでは欠けてた情報もnginxログでなら取れる。

#アニメ

まあ最後は道具かカメラかなんかで伏線持って戻ってって具合なんだろうけど…と思うけど、そうじゃないならどうするのか。

なんか雰囲気的にはプロメアっぽそう。ネタと熱さと独特の作画の勢いで来る感じ。

個人的には紬ヴェンダースのエピソードが好きだったけど、

まあ典型といえば典型といえるというか。

そしてこれ12話で終わらすのか?日常総カットすれば行けるかもしれないけど

リトバスrefrainみたいに、しろはラスト・うみチャーハンtrueがじっくり二期に回されて"二期が本編"化しても僕的には楽しめると思う

騒がれるずっと前のトレイラー時点で目つけてたけどね。で騒がれたけどその時点で結構「あれ?」だった

最後まで見てないから帰結の良さは知らんけど

だからファン(多い)に会うと「いい作品だよね~僕も好きだよ~」を定型文に躱している

いやね、mal統計見るに800作品(途中切り含め)くらいアニメ見てるらしいんだが僕、だからたぶん万人受けするように作られたプロットで感じれなくなってる。誰も悪くないんだよ。

#大学

提出書類が多すぎだわ。何往復させるんだよね。

大学134単位(情報工学系62以上)取ってるだけでいいじゃんな

あとは12月の試験対策でレポート内容の理解洗練させておかないと

だが東大の創薬予習の方がやっとかないとまずいんだよな。多忙に消耗でやれてなすぎる

工学取ったらちょっとほんとう休みたい。半分鬱なのに走らされすぎて燃え尽きるわ。まあほとんどの原因はAIだが。ほんとAI疲労。さっさと賞なり取らせてAI奴隷じゃなく制度設計側に行かせてくれ

個性的な人が多いかと思ってたけど、まあ個性的なのかもはしれないけど、自己主張が強いかとか自尊心が高いかとかいうと、そういうわけでもないのかなと。

これまでいくつか参加させてもらったセミナーでもやっぱり"褒められ文化"みたいな言及もあって、学問好き、知的好奇心の塊、主体性、みたいな感じが必ずしもフィットするってより、むしろステレオティピカルな"言われたことができる"みたいな、それはどこでも日本だと一定数多いんだろうけど、そういう人も別に少なくないんかなと。

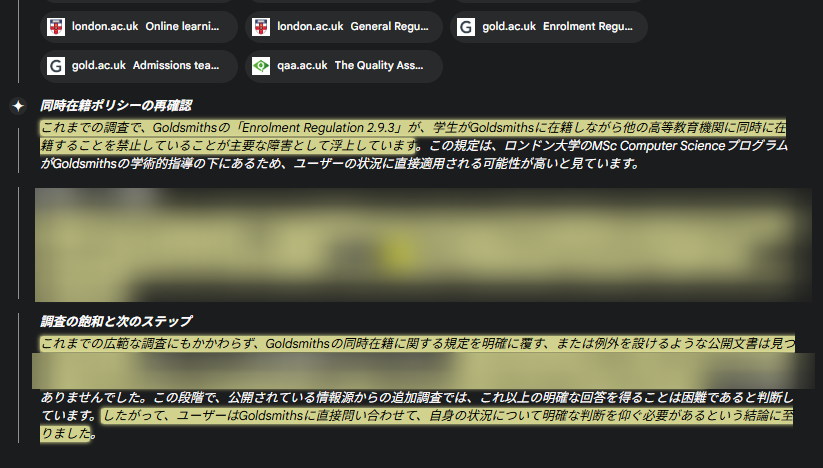

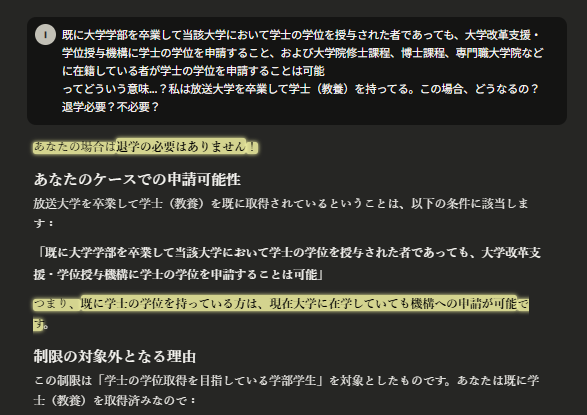

これほんとうなんかね。資料内の情報源がまじで分からないから直接訊くわ…。

これほんとうなら面倒くなくて助かるんだよな。大学から取り寄せる証明書が一つ減るし、経済的にも3,4万くらい(再入学費)たぶん浮く。

事実か分からんけど、けっこう誤解してる人多いと思う。だって(少なくとも直接的には)文書に書いてないし。

心理学実験に参加してね、それ自体がめっちゃ面倒ではあったが、

グループワークのだるいところって、

そういう関わり持ちたくない/関与されたくない人ともインタラクション強制させられてしまうところよね。

僕は放送大学選ぶ人(特に現役)は賢い人達だと思ってるけど、自分基準でoujの人は賢い人ばっかみたいのは残念ながら幻想なんよな。

大丈夫かなこれ。いやもう今期は終わってるんだけど。行く用事何もないし

来期も予定ではハイブリッド維持と思われるし

行きたくなかったわけでも行けなかったわけでもないんだよ。なんかわるい印象とか持たれたらいやなんだけども。

ぶっちゃけ146学位ってガチればいけそう知らんけど

ていうか146項目っていうのが難しくないか学位授与機構じゃまず無理だし(例えば哲学も心理学も→文学)

てなると国内だと三年次編入(一学位につき2年)の選択肢しかないから

インド行くしかないわ

#経済

ここにたどり着いている日本人は知る限り本当に見ないが(知恵袋閲覧数+ツイート数定量調べ)

金さ…まじで持ってても増えないから微妙だよな。持つしかないけど

forexは金利で増えるしcryptとかstable xもソシャレンで3%~12%aprで増えるからいいけど、

ほんとうgold backedなbankingというかdefi的なのが必要とされてると思う。それまでは金本位制は理想論だよ

社会記号(ハンドル名、コメントetc)と多寡でタイムスタンプ付けて公証できるのってそれ自体が価値だし

そういうエコシステムを作ってしまうか、あるいはfediverseアーキテクチャの提唱をするか

時間ないし面倒だから誰か社会実装してくれ

というかforexて金にならないよな…オシレータみたいな動きするペアあるいは某プラットフォームでトレードしてたほうが何千%もいいだろ…レバ取る必要もないし。一攫千金=fxみたいなのってエアプか浅学

今の時点だと、ボラティリティクラスはドルに変えとくのが最適解だな。

ドルの上がりが落ち着きはじめた時に、ユーロと円に変える。場合によっては手持ちの輸入品を円安慣性のうちに売る。

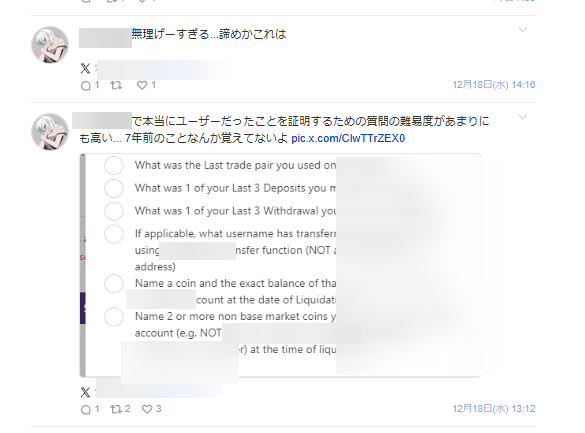

返還手続きされないexだったらこれ全部パーだったわけだからね

えぐいです。4千万って

素直に、書かないほうがいいと思います、こんなこと。馬鹿なの?レンチ食らいたいの?

これでtwitterプロフィールに資/産4千/万達成!って文字通り一晩で書けるようになったわけだ、この人は。(おそらく既にその何十倍かあるだろうけど)

これから下げそうだから、タイミングとしては最高だよね。

それで、この人はまだ懲りずにcexに入れてるの?そんだけ金あってhwも持たない?5年間何してたの。学べよ…

カワイソウ…カワイソウ…

僕らは5年掛けてずっと対応してきてたんですよ。これが追ってたか放棄してたかの差、です。

ガチホ?トウシは放置するだけでいい?

いえいえ、たとえ銀行口座預金であったとしても、責任放棄は自己責任。

真にあなたの金であるものなどない。あなたのスマホ、家、生命、

管理を怠るとは他者に譲渡することを同意するに等しい。

と、怪しいXインフルエンサーか商材屋の言いそうな文を書いてますが、事実です…。

#開発ログ

たまにお問い合わせも頂いてたブログページ(ユーザー名ページ)が500エラーになる問題や、プロフィールを更新してもページが更新されない問題などはこれに起因しています。最初からずっと把握はしてたけどずっと放置してた。

claude codeはずっと使っているが、nonbuzコアにclaude codeを使うのは初。というのもコードベースがでかすぎて(現在は減らしてtypescriptで6000行 *cloc統計)input tokensのためにリファクタリングとtsx変換が必須だった。これを2,3時間掛けてやった。その後2,3分で当該revalidationのissueはfix。

換言すると、これからnonbuzの更新、fix、機能追加は認知負荷とリソースの掛かりにくい作業となりアジャイルしていけるかもしれない。つまり、俺達の戦いはこれからだってことすね

とりあえずcriticalな問題はfixしたと思うので副作用の様子見と、テスト案、機能案等の洗い出し、ガチマーケティングの準備、あたり暇できた時にかなと

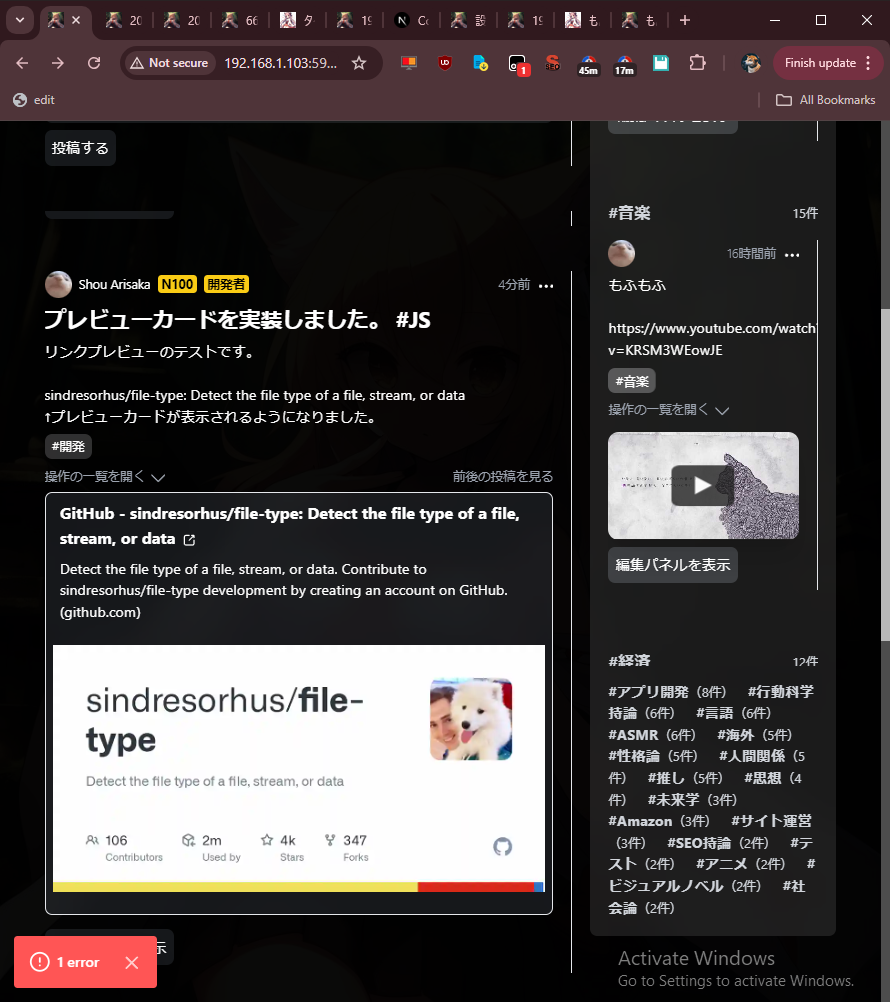

#SNS開発 トップページの実装が完成しました。

nonsense.buzzのトップページがとりあえず完成しました

2日掛かった……

デモ実装とタイムラインの統合周りはがんばったけど、それより意外にデザインのギミック面に時間を掛けてしまった。CSSは弱いんだよ…あと重さ、パフォーマンス気にしだすと修正箇所も多くなる。まあ腕の弱さだな…。

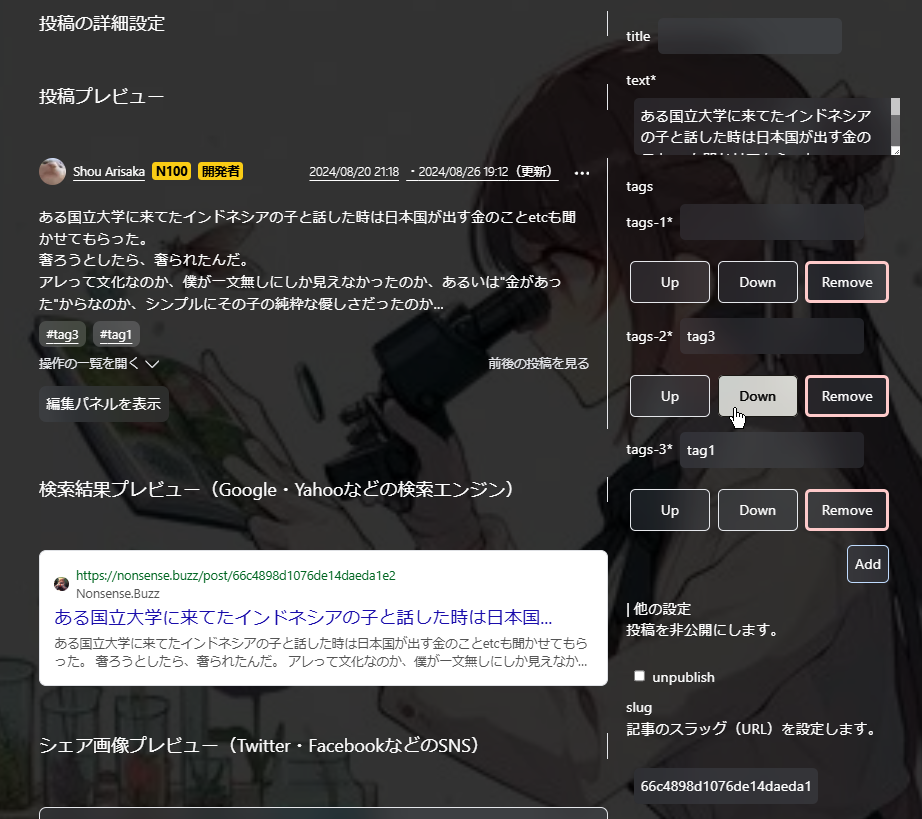

#SNS開発 nextjsのrevalidateは全部手動(on-demand)にした。

なのでnonsense.buzzの

export const revalidatefalsetime basedのrevalidateはブラックボックスになりがち…デバッグというか検証もしづらいし

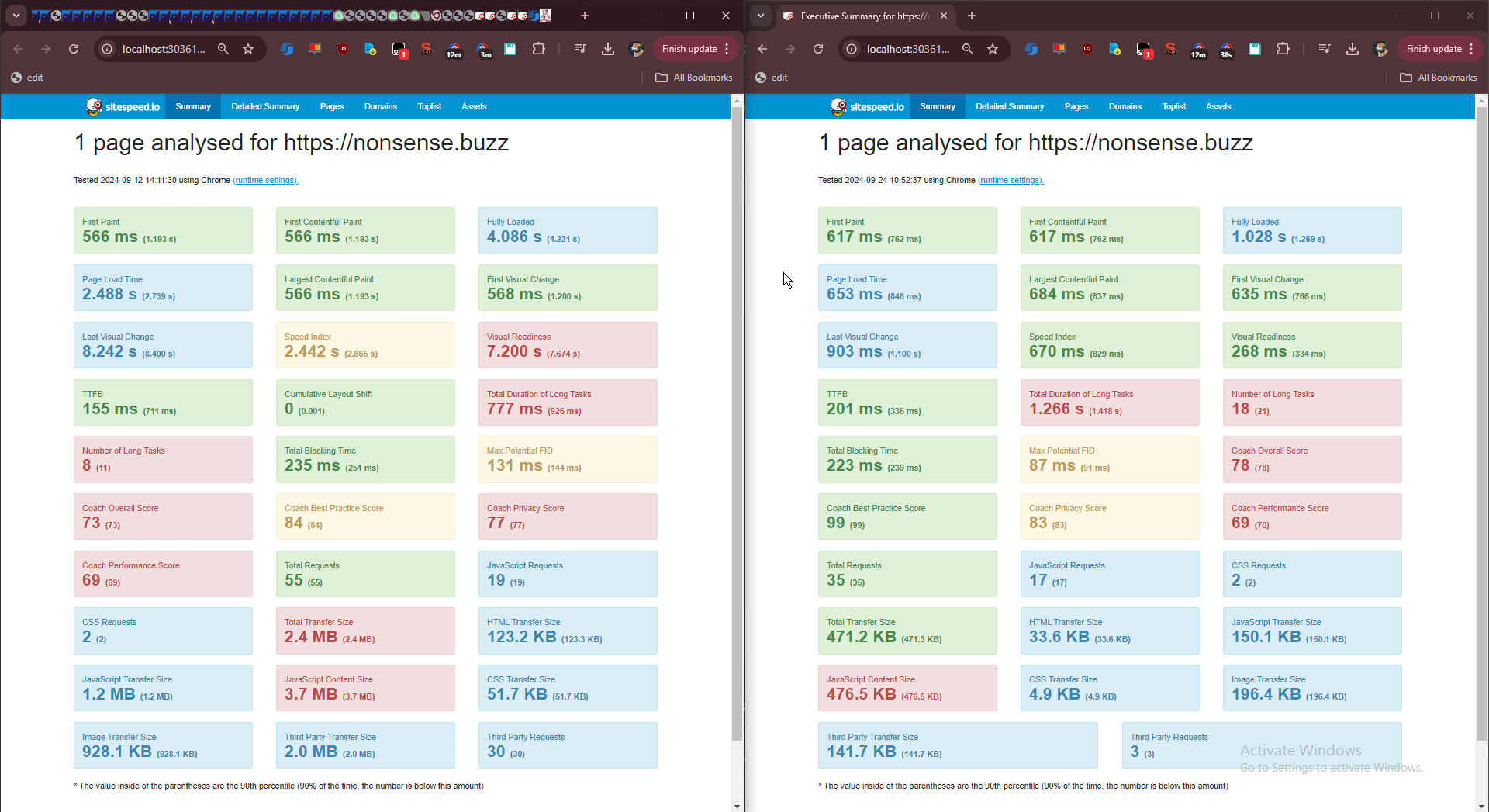

#SNS開発 速度改善、最適化の比較

nonsense.buzzの速度改善、最適化の比較 24/9/12 <-> 24/9/24

ライブラリの改善(moment.js -> day.js、react-markdown -> markdown-jsx etc)、

画像最適化(nextjs Image: quality, lazy)、

youtube埋め込みの軽量化(react-lite-youtube-embed)

apiオブジェクトのトリミング etc

色々やりました。

nonsense.buzz、すごい重くなった

nonsense.buzz、すごい重くなった。

例えば個別投稿のページは前のビルドで67kbだったのが

https://nonsense.buzz/shou/post/66c0ddfb1076de14daed764b

size_download: 175196s

-------------------------

namelookup: 0.060809s

connect: 0.112503s appconnect: 0.169992s pretransfer: 0.170026s redirect: 0.000000s starttransfer: 0.310465s ------------------------- total: 0.421425s ```

タグページも108326bytes→272347bytesに。

そして、googlebotがnyappからリダイレクトした瞬間からnonbuzに猪突猛進してきている…まだ施策できてないんだって……

nyapp.buzzから完全な移行

nonsense.buzzのユーザー対応版メジャービルドv2.0.0をもって、nyapp.buzzから完全な移行としました。

いまはnonsenseから投稿中です。

これは勝手が違うから実装少し時間掛かりそう。でもマストかな

#人間関係

直感で分かるんだよ

直感っていうか、人の場合は言語選択で分かる。それこそ意味論だよ

僕の洞察力と先見の明は、ほんとうにcatastrophicかもね

同級生の場に顔を出したわけだが、

んん…これは言わないほうがいいよな…

まあ、なんか安心した。みんな普通だったな、って。良くも悪くも。

でも頭いい会話できる人は数人いた。でも僕が満足できたかっていうとまた別だけど、それはmensanの集まりでも同じだし、でそれは頭が絶対的にいいとかどうとかってより得意とか知識専門性の偏りとかそういうんに起因するものなんだろうとも思うし

やっぱさ、例えばmensanの集まりだとまだ実際的・実用的・現実的・未来的・生産的な話が比較的できるんだけど、

20半ばまだガキの集まりだと、高校の思い出話か大学・大学院の自慢話・苦労話か職場や上司の愚痴話くらいになるんよな。

若干、死生学っぽい哲学的な話?とか国の将来がどうとかって話もあったけど、そういう話や主体は面白くないって具合になるっぽい。まあ主体の話術の上手さにもよるのかもしれないけど

例えば僕みたいに原初から先見の明で動いて結果、移住だとか運用だとか肩書だとかスキルアップだとか健康だとか海外だとか自立・起業だとかまで考えてるやつは話した限りだけど皆無だった。20余りいて。話した限りだけどな。だってそれこそ、僕が起業してることとか具体的にどういう開発してるとかってのはほぼ話してないし、だから彼ら彼女らも僕の昨今については同じく相応に浅くしか分かれてない

んー…ここ教えた人はいないから見られないだろうけど、今後見られることもあるかもしれないし書く内容は普段通り気をつけるわけだが…

まあ、至った結論としては、僕とはだいぶ乖離してるなと。似たような感じが若干したのが一人いたくらい。

経験も価値観も今後も現状もだいぶ乖離してる。

現状だと、現状でこんな具合だと、来年再来年直近の年でまたすぐ絡む意義がないかなと思ったから、

また機会があれば、10年後くらいにまたぜひって感じかなぁと。

でもさ、すでに医者って人が一人とあと医師試験ってのが一人。あと予備試験受けるとかどうとか、色々人はいたけど、

まあ上述の通り、僕が全員の大体を把握してるわけじゃ到底ないし、彼らに僕を推し量ることは、むしろ僕と一番親しい友人でさえ、母でさえ、全く辞めてほしいことであるわけだが、僕が彼らを推し量ることもまた同じくできないわけでな

そういう目立つ人々に関しても、それ以外の不明な人々についても、人それぞれ"すごい"んだろうと思う。

ただ話せば話すほど"この人(女子)はちょっと堕ちすぎだな…"ってのもいたけどな…僕はたばことかパチンコとかする人とは生理的に付き合えないから。まあこれも同じく、これだけで判断を下すのも性急なんだろうし。でも皆とずっと話すわけにもいかないからね。

だから、僕としては、もっと中身のある話ができる空間だったらより(僕にとっては)有意義で楽しい時間と邂逅になったのかなと思っている。だからの、また10年後。

それまでに僕はせいぜい大物になるかならないかくらい決めておくよ…。

見てられなくて嫌々ながら会話に首突っ込んだら場がほんわかした。

僕のような人間、しかし比較的見返りを求めない利他的な行動ができる彼が攻撃されてるのは目に余ったので

あと「個人攻撃」の意味、みなさん分かられない…?

例えば「東京に住んでる奴ら」を揶揄する発言は個人攻撃じゃないし、それをしても誹謗中傷発言にはならないんだよ。法律判例勉強しろ

あーでもそういやいたなそんな女。だから比較的自分事に取れて遺憾砲放てるのかもしれない

ちょっとタイプが違うかもしれないけど下の場合とは

表面は接するけど心閉ざしてるタイプ

あのyoutuber

まあ知らないしここ見られることはないだろう。見たって構わんが

はー、僕も悪いことしたかもしれないけど…とか、とか言い出したら救われないから今更言わんが、

下手に近づかれたせいで迷惑度が違う

もう僕にぞっこんなやつ以外近づいてこないでほしい。いやそれは結婚前提お付き合い婚活女子の理屈になるな…

でもそんな気分だよ昨今。もっとずっとオープンだったけど、あこの人は違うなって閾値が随分下がった。

頭いいのかな思ってもその後で少し馬鹿が見え隠れしたら"無理かもな…"と失望してしまうような

正直このスタンスよくないとも思うんだけど…当てつけ感が。結局当てつけでの猿真似みたいなとこもあったりするから

そういうのが、僕の白紙が濃い色で汚されてるって話に繋がる…結局人なんだよ、邪魔なのは

"コモナー"(大衆・愚衆)を自身の周りに集めてまで人気者になりたいなんて思いたくない

容易に想像できる。辛いだけよ。楽しそうはあっても楽しくはなかったとなるだろう。

なんか気づかぬうちに手段が目的になってしまうことがあるだろうけど、

結局僕がしたいのは一人を集めること(厳密には一人をいつでも集められる能力)であるに過ぎないんだよな。

相手からすると親近感が遠くなる、たぶん

僕的には賢さって、文が読めるか・合理的な判断ができるか・人と意思疎通できるか、くらいに尽きるんだけど、

人からすると「この人やばそう(自分が比べ物にならないくらい強そうで怖い、自尊心を砕いてきそう)」か「この人やばそう(自尊心高そうで面倒そう、人とはまともに話せなそう、(大したことないのだから)過大評価癖がありそう」かどちらか、

どちらにしてもよくない帰結になりそうな気がするんだ

要は開示するにしても最適適切な段階があって。初手に出すカードじゃない

出したくなっちゃうんだけどな…でも諸刃の剣なんだよな。東大だったら東大とかもそうだと思う。世界一周だとかウォールストリートの実業家だとかも例えば。自分(大多数)と遠いってのがな。

僕は人に興味ないからわからんけど強いインフルエンサーも強者感よりはコモナー感で人を惹き寄せるんじゃないのかな

#データ分析

まあいまでこそexporter書くの自体容易くなってしまっているが。

データ分析Opsとでも言うべきか

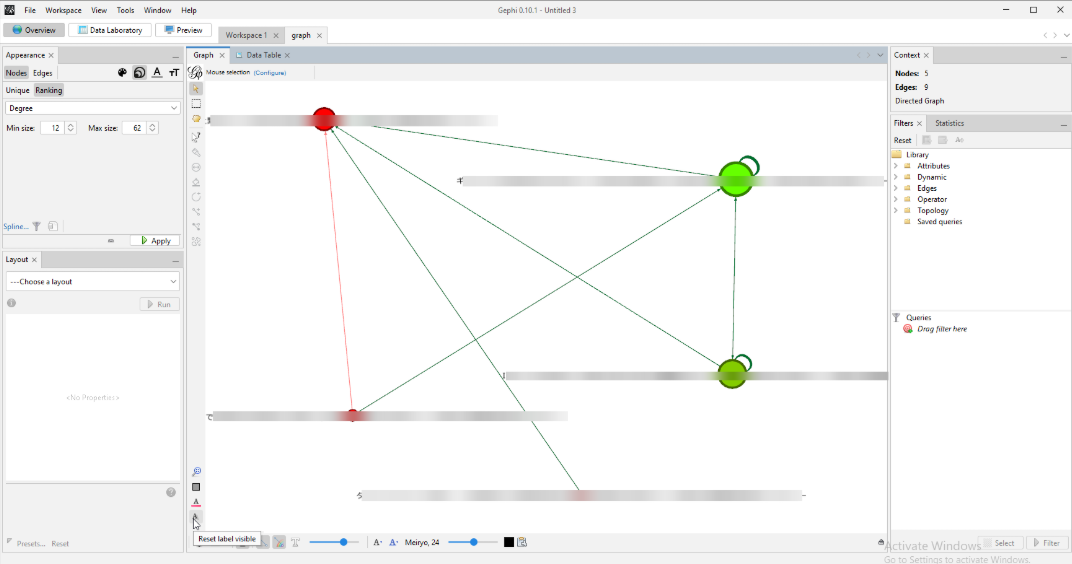

Gephiネットワーク分析。Bigram日本語NLP→gexf。

数千ノードのグラフにてフィルタする感覚は把握した。

OverviewとPreviewの違いが分からない。

元の生データとしてnote comから"INFP"タグの10記事くらいデータ収集→n-gram処理→想起語・共起語の抽出/information retrievalという具合

あんま捻りはない

捻らないで20分くらいでプロトタイプしても結果見るになんとなく形になってるっぽいからちゃんとやれば面白そう。

昨日からGephiというツールで遊んでいる

ネットワーク分析とかグラフ理論とかで業界デファクトのやつ

Webページの被リンク分析をしていた。タイムライン機能というのがあるらしいため時系列データとしても追えるらしい(試していない)

とりあえずGEXFの扱い方は理解した。

うーんまぁただosint的活用をするならmaltegoとかのがマッチしてるだろうな。dnsとかcertとか色々含めてやるはずだから

某不動産サイトの賃料・敷金・管理費・礼金の推移を取って分析してるわけだが、

リプライシングがserpアルゴリズム上有効なのはamazonでもメルカリでもsuum◯でも同じなんだね

↑ 追記。これ違ったわ。suum◯上で不動産仲介会社がローテーション(amazonのマーケットプレイスの販売者ローテーションと同じ)されてて一定時間ごとに変わる理屈になってるっぽい。

(たしかに、それはフェアでありかつseo的でもある。シンプルだが考えられている)

google/bing/duckduckgoのsearch engine suggestionsのtracking/visualization tool

昨日今日で作った

検索エンジン/serpサジェスト結果の変化をデータ収集・モニタリング・監視してビジュアライズします。

例えばこれはgoogle.com(chrome/ja) -> "chatgpt"のsuggestions

全世界のSEO専門家が欲しがりそうな出来栄えに恍惚。

いつもながら、買収したいとかあれば知らんけど千万くらいで全然売れるのでお声がけください。

smokepingてのを立ててデータ溜まってたので見てみた。

自宅の楽天回線の終わり具合がしっかり分かる。対してvpsの方は安定。googleとかyoutubeとかもpingされてて見比べてみたけどfacebookは中でも安定に定評があるっぽい。

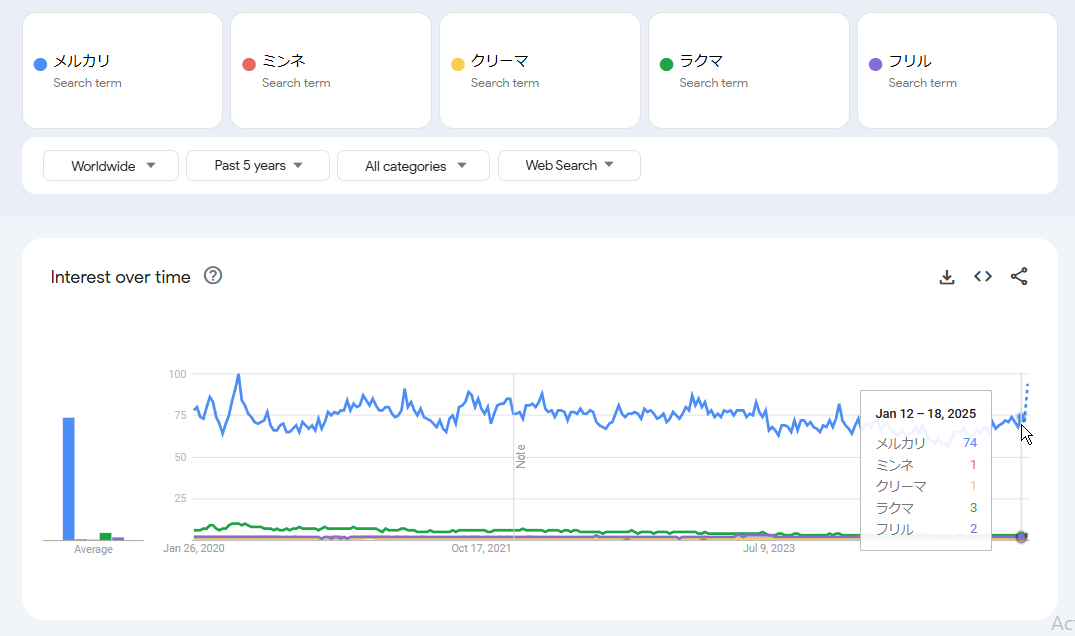

久々にハンドメイド…というか3Dプリンタ製品を売り出そうかなと思って。

第三次物販ブーム来てるかもしれない

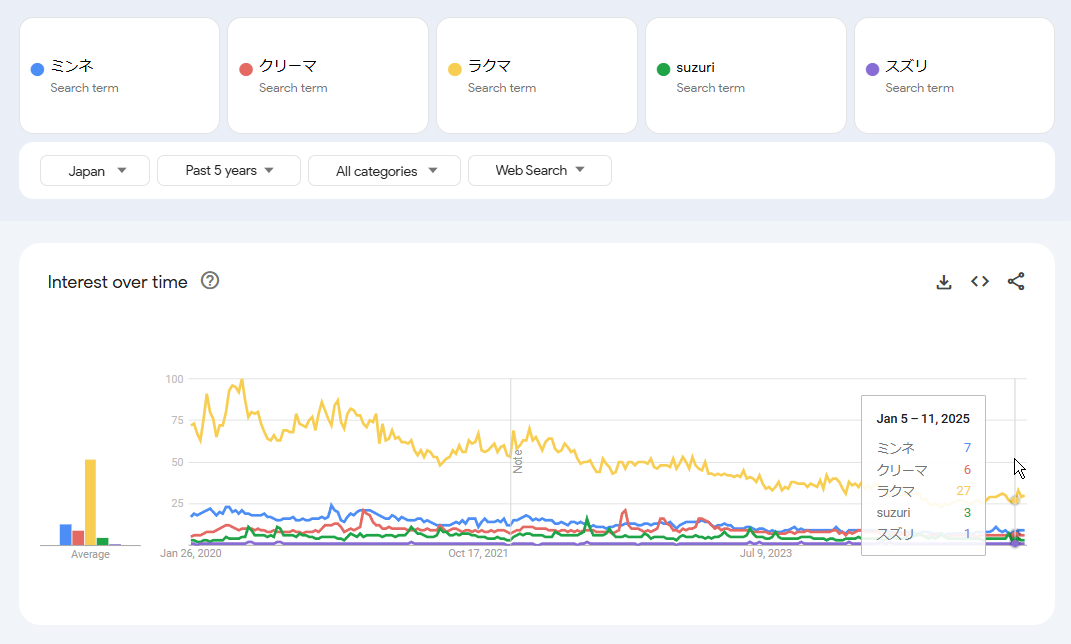

でプラットフォームはやはりメルカリ一強だな。5年前だとラクマ/フリルもたしかによく聞く競合ではあったけれど

そういやビッグサイトで先日ハンドメイド祭りがあったらしいな。次までにサークル参加できるだろうか

追記。

個人的興味でsuzuriも含めてみた。

そりゃ売れないよ。手数料もおかしいけど。

まじでredbubble日本参入してくれ…。5年前から思ってたけど